Il est difficile de garantir la sûreté des systèmes autonomes à base d’IA, en raison de la complexité de leurs composants logiciels et de l’utilisation du deep learning lors de leur conception. Pour combler cette lacune, le CEA-List propose une architecture pour la supervision de ces systèmes en cours d’exécution.

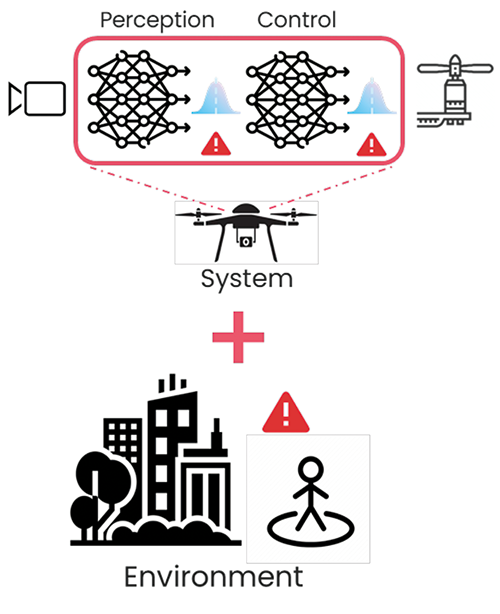

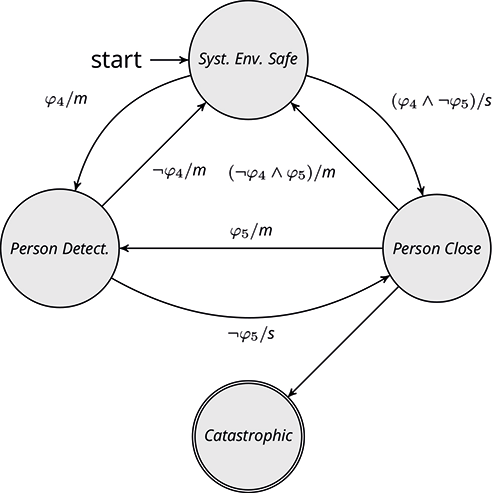

Celle-ci contient d’abord des règles formelles de sûreté issues de l’analyse de risques du système, après identification des variables et des situations qui seront à risque au cours de l’exécution. Pour les variables du système, nous considérons les mesures de confiance fondées sur l’incertitude. Sur la base de ces règles, un modèle des comportements sûrs est construit pour identifier l’état de santé du système et de son environnement. La santé du système est liée aux risques fonctionnels inhérants aux composants IA (comme le traitement de données éloignées de ce qui a été appris), tandis que celle de son environnement est liée aux risques qui découlent de l’environnement à un instant donné (figure 1). En fonction de l’état de santé du système et de son environnement, différentes actions peuvent être entreprises pour maintenir le système dans son état ou le remettre dans un état sûr. Lors de l’exécution, le superviseur de sûreté reçoit des informations venant des autres composants et les compare à son modèle de comportements sûrs, ce qui permet de déclencher des actions le cas échéant.

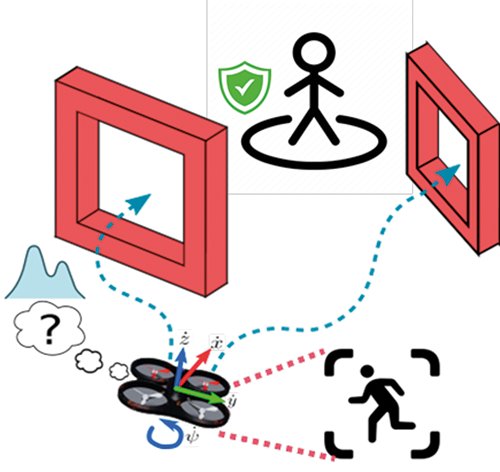

Les équipes du CEA-List ont appliqué l’architecture de supervision à la navigation autonome d’un drone au travers d’un ensemble de portes dont l’emplacement est inconnu à l’avance (figure 2). Elles ont pour cela utilisé l’environnement de simulation AirSim. Le drone est composé de trois blocs fonctionnels distribués utilisant le standard ROS2 pour la communication :

Notre cadre de surveillance permet de superviser les composants basés sur l’IA dans des architectures robotiques hautement modulaires et distribuées au cours de tâches critiques pour la sûreté.