L’hybridation entre apprentissage automatique et simulation numérique ouvre la voie à des avancées scientifiques majeures dans le domaine de la physique computationnelle. À titre d’exemple, la mise en œuvre des simulations numériques sur lesquelles repose l’étude des propriétés des matériaux à l’échelle microscopique est limitée par la lourdeur du calcul des énergies et des forces atomiques. Pour contourner le problème et accélérer ces simulations, des modèles d’apprentissage profond sont utilisés pour apprendre à prédire les quantités coûteuses.

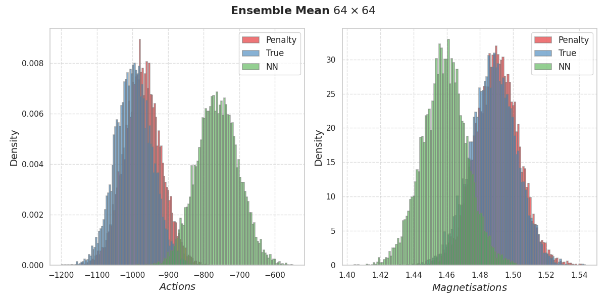

Toutefois, malgré des performances satisfaisantes en prédiction, l’incertitude inhérente aux modèles obtenus par apprentissage profond introduit un biais dans le calcul des observables physiques issues de la simulation. En effet, l’apprentissage automatique se base sur un ensemble d’observations qui servent à ajuster au mieux un modèle dont les paramètres sont incertains. Les biais de simulation induits par cette incertitude dite « épistémique » représentent une limitation clé dans le déploiement de l’IA pour les simulations numériques.

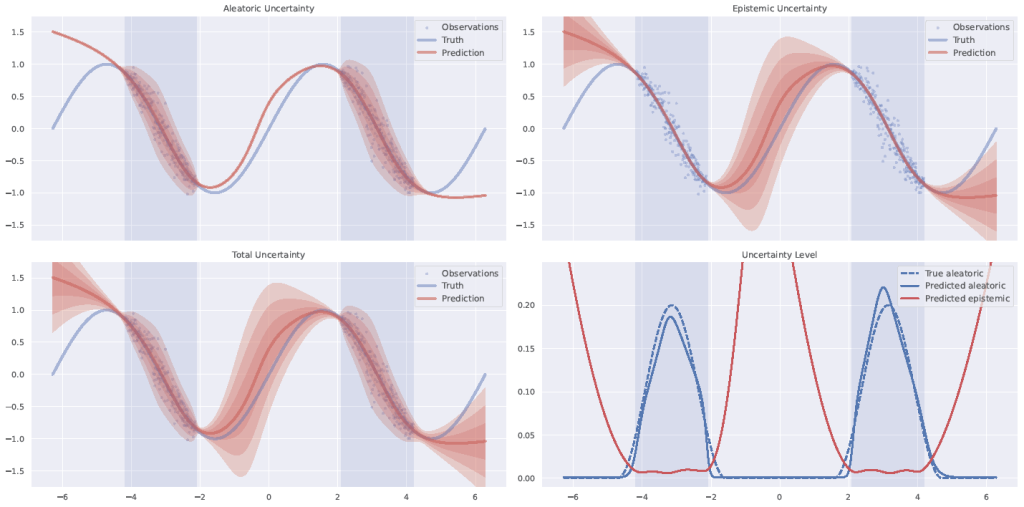

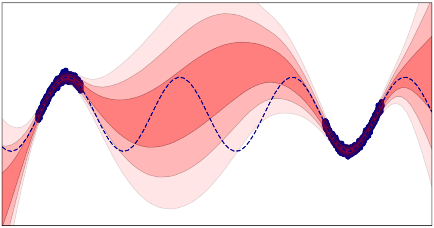

Nous développons des méthodes de quantification d’incertitude des prédictions de réseaux de neurones afin de concevoir des techniques innovantes de correction des biais de simulation. Ces méthodes se basent sur l’inférence statistique bayésienne, afin de calculer la probabilité qu’un réglage des paramètres du réseau de neurones soit correctement ajusté au regard du nombre limité des observations disponibles. Cette probabilité dépend du bruit que les données peuvent contenir : cette seconde incertitude est nommée « aléatorique ».

Le logiciel CAUTIONER (unCertAinty qUanTificatIOn Neural nEtwoRk), développé au CEA-List, est capable de calculer l’incertitude d’un réseau de neurones en le transformant en réseau de neurones bayésiens, défini par la distribution de poids et de biais probables. Ce nouveau modèle ne peut pas être « entraîné » par des algorithmes conventionnels. Grâce à l’expertise du CEA-List en matière de programmation probabiliste, CAUTIONER est basé sur des algorithmes issus de la famille des méthodes de Monte-Carlo par chaînes de Markov (MCMC) qui représentent l’étalon or en matière de calcul de prédiction et de son incertitude. Ce logiciel est accessible au CEA sous la forme d’une librairie Python, incluant les interfaces API du composant, une documentation et une interface graphique afin de faciliter son utilisation sur cluster avec GPU.

De plus, nous développons de nouveaux modèles de réseaux de neurones profonds probabilistes avec la dernière couche bayésienne (Bayesian Last Layer – BLL). Version réduite du réseau de neurones bayésien classique, où seule la dernière couche est probabilisée, cette approche a l’avantage unique de permettre l’évaluation de l’incertitude de prédiction par conception car elle peut être calculée analytiquement. Cette expression explicite a permis le développement d’un algorithme d’optimisation performant type EM (Expectation Maximization) pour l’apprentissage des paramètres du réseau de neurones.

Ces outils de quantification des incertitudes permettent de concevoir des corrections des biais pour les simulations numériques évoquées ci-dessus, ouvrant la voie à des avancées scientifiques en physique computationnelle et en science des matériaux.