Les systèmes à base d’intelligence artificielle (IA) sont vulnérables à des menaces tout au long de leur cycle de développement. Les outils PyRAT et PARTICUL développés par le CEA-List permettent de détecter et de se prémunir contre les attaques adverses.

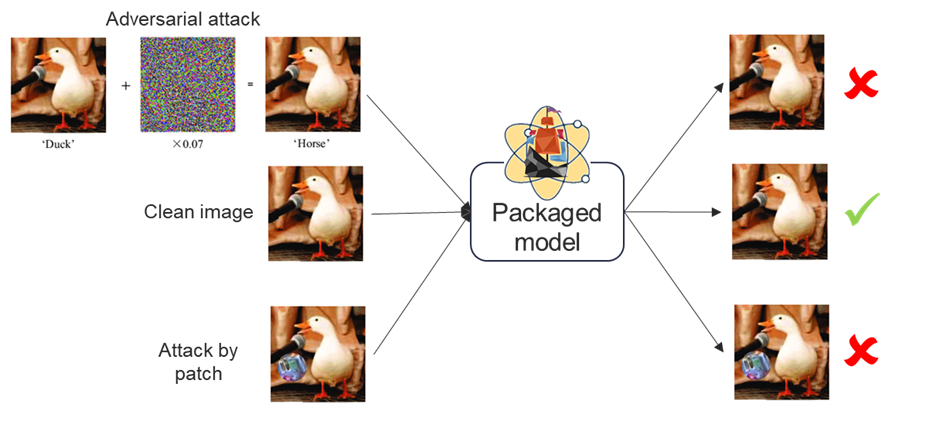

Les récentes avancées en matière d’intelligence artificielle ont permis une rapide popularisation des systèmes à base d’IA qui font désormais partie de notre vie quotidienne et sont présents dans de nombreux domaines industriels. Comme tout système informatique, les systèmes à base d’IA sont vulnérables à de nombreuses menaces durant tout leur cycle de développement, de la collecte de données en passant par l’entraînement jusqu’à leur déploiement. Dès 2014 leur fragilité face à des attaques adverses a été démontrée, des perturbations ajoutées à l’image permettent d’altérer la décision d’une IA tout en restant imperceptible à l’œil nu. De manière similaire, des attaques dites par patch permettent par un simple sticker positionné à côté d’un objet d’en altérer sa reconnaissance par une IA.

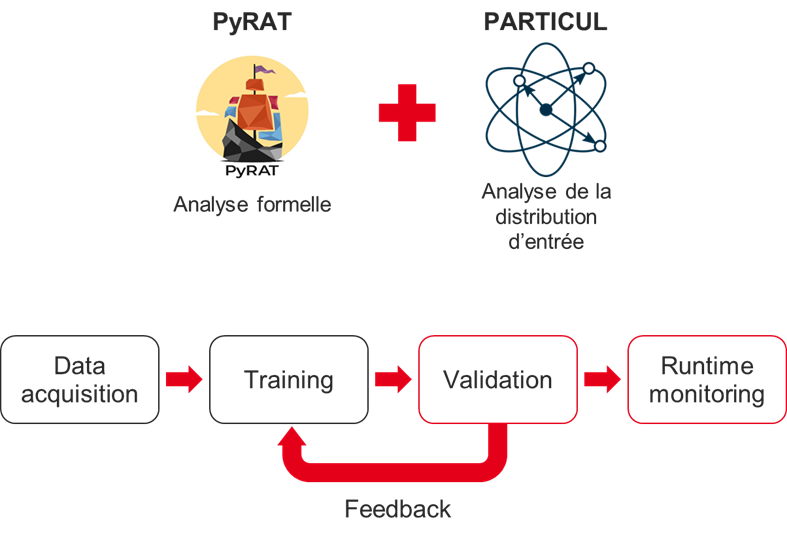

Le CEA-List propose une solution combinant les outils PyRAT et PARTICUL pour faire face à ces attaques adverses. PyRAT est un outil de vérification formelle de réseau de neurones qui se base sur l’interprétation abstraite et permet d’apporter des garanties mathématiques fortes de sécurité sur un modèle IA. De son côté, PARTICUL permet de construire des détecteurs de parties récurrentes dans un ensemble de données pour les associer à une mesure de confiance sur leur présence ou non dans les entrées d’un modèle. Leur utilisation et combinaison durant la phase de validation et de monitoring d’un système IA permet de se prémunir et de détecter durant l’utilisation les attaques adverses.